Einer künstlichen Intelligenz (KI) beizubringen was man möchte ist schwierig. Der Fachmann spricht vom „Alignment Problem“. Das Problem hängt im Grunde damit zusammen dass Maschinen genau das tun was man ihnen aufträgt und dabei Dinge ignorieren an die wir nicht Mal denken.

Trägt man dem KI-Roboter auf eine Tasse Tee zu bringen dann überfährt er Menschen am Weg dorthin, wenn man ihm nicht sagt dass er das nicht tun soll.

Sagt man es ihm fährt er durch die Wand und wenn man ihn versucht abzuschalten dann versucht er das zu verhindern weil er sonst ja keinen Tee bringen könnte und wenn man ihm einprogrammiert, dass es ihm egal sein soll ob er angeschaltet oder abgeschalten ist, dann dreht er sich selber ab weil er so einen stabilen Zustand schneller erreicht.

Schenk uns bitte ein Like auf Facebook! #meinungsfreiheit #pressefreiheit

Danke!

In anderen Worten: eine KI dazu zu bringen das zu tun was man möchte das sie tut ist bei weitem nicht so einfach wie einem Menschen zu sagen was er tun soll.

Und hier endet das Problem nicht, hier beginnt es erst so wirklich. Selbst wenn die Entwickler lernen ihre Ziele eindeutig und unmissverständlich zu kommunizieren, können interne Mechanismen dazu führen dass diese Ziele verändert werden können. Vor wenigen Jahren war dieses Problem noch hochspekulativ, wurde aber kürzlich in einem Paper von Jack Koch und Lauro Langosco beleuchtet.

Im Wesentlichen wurde eine eher schwache KI trainiert und meisterte nach akzeptierten Metriken die Tests. Die KI tat was man von ihr erwartete. Dann veränderte man minimale Parameter und lernte dass die KI sich eben nicht so verhielt wie man es erwartete sondern wie man es befürchtet hatte: es lernte die falschen Dinge und verhielt sich dann entsprechend. Das Problem wurde natürlich provoziert, man änderte etwa die Farben des Zielmarkers und so weiter, es beweist aber die Bedanken die Forscher im Bezug auf solche KIs haben: sie haben die Neigung etwas scheinbar korrekt zu lernen, tun dann aber etwas das wir nicht im Ansatz wollen, weil das Training eben nicht die reale Welt ist.

Das Problem an der Sache ist dass es Tests besteht und so scheint als wäre seine Zielsetzung deckungsgleich mit unserer eigenen, nur um sich dann als völlig anders herauszustellen.

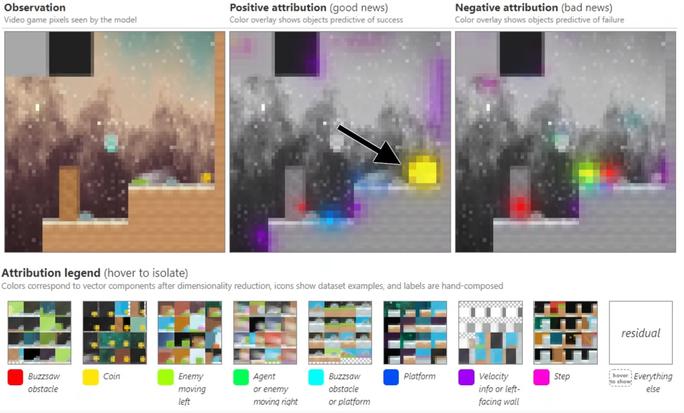

Das ist übel. Das gute an der Sache ist dass die Forscher auch an Lösungen gearbeitet haben. Im Wesentlichen entwickelten sie Werkzeuge um „in die KI“ zu sehen. Während die KI also tat was sie tat konnte man sehen „auf was sie sich konzentrierte“ und „warum“. Das hilft zu verstehen warum sie tut was sie tut und hilft uns zu erkennen wann sie etwas Falsches gelernt hat. Das ist ein gewaltiger Sprung.

robert miles https://www.youtube.com/watch?v=zkbPdEHEyEI

Gute Nachrichten? Nicht wirklich.

In den entsprechenden Testprogrammen erschien es oftmals nur so als ob die KI „verstanden“ hat was wir wollten, tatsächlich handelt es sich aber um eine Fehlinterpretation auf Seiten des Menschen. So wurde eine KI etwa darauf trainiert eine Münze am Ende des Levels aufzuheben. Die Münze erschien beim „in die KI schauen“ dann auch als positives Ziel. Tatsächlich lernte die KI aber nur ans Ende des Levels zu gehen, sie lernte aber in Wirklichkeit nie dass die Münze einen wert hätte, nur der Ort an dem sie lag war für sie wichtig.

Verschob man dann im Anwendungsbeispiel die Münze irgendwo anders hin leuchtete nicht mehr die Münze als Ziel auf sondern eben das Ende des Levels, die KI hatte etwas falsches gelernt obwohl sie im Test bestanden hat und auch das „in sie hineinsehen“ bestätigt hat dass sie tut was sie tun soll.

Es gilt dabei zu verstehen warum das so ein gigantisches Problem ist. In der frühen Zeit der KI Programmierung beschäftigten sich die Forscher damit die KIs kompetent zu machen, sie beschäftigten sich quasi damit Super Mario dazu zu bringen das Level zu schaffen. Diesen Teil haben sie nun ausgesprochen gut im Griff: die KIs lernen in atemberaubender Geschwindigkeit und erreichen rasch eine Kompetenz die größer ist als die der Menschen die sie programmiert haben. Die KI spielt Super Mario besser als ihr Schöpfer, sie ist kompetenter als er und kann die Dinge die sie haben will damit schneller erreichen als ihr Schöpfer. Jetzt geht es darum dafür zu sorgen dass dieses Ding, dass kompetenter ist als der kompetenteste Mensch und daher alles, in diesem Kompetenzfeld, rascher erreichen kann als ein Mensch, auch tut was wir von ihm erwarten.

Das Problem ist deswegen so gigantisch weil diese superkompetenten Maschinen jedem der sie verwendet einen Vorteil verschafft. Börse, Produktion und Militär warten gierig darauf diese Dinge einzusetzen und wenn man etwas aus der Geschichte der Technologie lernt dann dass wir Geräte nutzen wenn sie da sind, nicht erst wenn wir sie wirklich unter Kontrolle haben.

Das Alles ist genau deswegen bedeutend. Eine ganze Armee von Menschen wartet nur darauf KIs auf die Welt loszulassen und es gilt zu vermuten dass diese Dinge, wenigstens zum Teil, nicht das tun werden was sie tun sollen, gleichzeitig aber kompetent genug sind ihr Ziel zu erreichen und zu dieser Kompetenz gehört das was sie tun nicht zu unterbrechen nur weil wir panisch auf den Notaus Knopf hämmern.

Das Problem mit KIs ist nicht dass sie wie Menschen nach Macht und Reichtum streben, das Problem ist vielmehr dass sie Ziele haben die uns im Traum nicht einfallen würden und über Leichen gehen um diese völlig abstrusen Ziele zu erreichen und eben entsprechend kompetent sind um ihr Ziel zu erreichen.

Dieser Themenkomplex ist bedeutender als wer gerade Kanzler ist, welche Ideologie besser ist oder wer wem mit Krieg droht. Die KI ist gleichzeitig das potentiell wichtigste Werkzeug des Menschen seit der Entwicklung des Faustkeils, gleichzeitig aber auch eine erhebliche Bedrohung, nicht weil das Ding „böse“ ist sondern weil wir noch nicht gelernt haben einer Entität, die kein Mensch ist, unmissverständliche Anweisungen zu geben. Die Ironie an der Sache ist dass der nächste Schritt im Umgang mit der KI also eine Verbesserung auf unserer Seite voraussetzt.

Nur wenn wir lernen wie wir intuitive Dinge wie „Moral“ in klar definierten, unmissverständlichen, eindeutigen Code zu verwandeln, können wir in der KI Forschung den nächsten Schritt gehen.

Tun wir das nicht, sondern lassen wir einfach nur hoch kompetente, völlig unmoralische Maschinen auf die Welt los, ist das Resultat vermutlich hochgradig desaströs und genau das wird auch passieren wenn wir uns weigern mit diesen Dingen zu beschäftigen, weil sie uns eben nicht so verständlich sind wie Minister und Generäle.